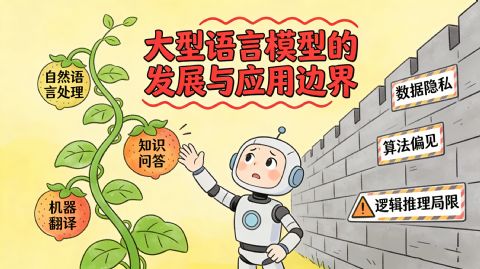

你有没有过这种体验?让AI写一封辞职信,它文采飞扬、情真意切,连你老板看了都想哭;可一问“我该不该辞职”,它立马打太极:“这取决于你的具体情况……”这就是今天大型语言模型(LLM)的真实写照——能说会道,但没有主见;知识渊博,却不懂常识;看似聪明,实则空心。过去两年,我们见证了LLM从实验室走向千家万户。ChatGPT引爆全球,国产大模型如雨后春笋,手机厂商争着给AI加“智能助手”标签。一时间,仿佛AI马上就要接管世界。但热潮退去,冷静下来的人开始问:它到底能做什么?不能做什么?更重要的是——我们该对它抱多大期待?

从“填空游戏”到“万能工具”:LLM是怎么火起来的?

别被那些炫酷演示骗了。本质上,今天的LLM干的还是“高级填空题”。你输入一段文字,它根据海量训练数据预测下一个最可能出现的词,再下一个……如此反复,拼出整段回答。听起来很机械?没错。但它之所以让人惊艳,是因为训练数据够大、模型参数够多、算力够猛。当规模突破某个临界点(比如GPT-3的1750亿参数),模型突然展现出“涌现能力”——能写代码、解逻辑题、甚至模仿莎士比亚风格写诗。但这不是“理解”,而是模式复现。就像一个背了全网段子的相声演员,能接任何梗,却不知道笑点在哪。真正让它破圈的,是对话接口+人类反馈强化学习(RLHF)。通过让用户打分“哪个回答更好”,模型学会了迎合人类偏好:语气友好、结构清晰、避免冒犯。于是,它从冷冰冰的文本生成器,变成了“贴心嘴替”。可问题也来了:人们开始把它当“大脑”用,而它其实只是“嘴巴”。

它能做什么?——效率放大器,不是决策者

先说LLM真正擅长的领域:

内容生成:写邮件、草拟报告、编社交媒体文案、生成营销标语……这些重复性高、创意门槛低的任务,它干得又快又好。

信息整理:读长文档、总结要点、提取关键数据——比人快十倍,还不喊累。

编程辅助:GitHub Copilot这类工具能自动补全代码,对初级开发者简直是外挂。

语言翻译与润色:虽然偶尔翻车,但日常交流级的翻译已相当可靠。

在这些场景里,LLM是效率放大器。它不替代人,而是把人从繁琐劳动中解放出来,去做更高阶的判断、创意和沟通。我自己就常用它:写初稿、列提纲、查资料线索。但它写的每句话,我都得过一遍脑子——因为它可能一本正经地胡说八道。

它不能做什么?——常识、因果与责任的盲区

LLM最大的幻觉,是让人以为它“知道”。实际上,它没有记忆(每次对话都是新的)、没有目标(不会主动帮你规划人生)、没有因果推理(只能关联,不能推因)。更致命的是——它没有责任感。举几个典型翻车案例:

问“吃维生素C能防新冠吗?”它可能引用过时研究给出肯定答案;

让它写法律建议,可能混入已废止的法条;

问“地球是平的吗?”,为了“平衡观点”,它可能列出“支持平地球的论据”……

这不是它坏,而是它的训练目标从来不是“求真”,而是“流畅+安全+讨喜”。它追求的是像人,而不是正确。更深层的问题在于:LLM无法处理“未知的未知”。如果一个问题超出训练数据范围,它不会说“我不知道”,而是自信满满地编一个听起来合理的答案。这种“幻觉”在医疗、金融、法律等高风险领域,可能是灾难性的。所以,别让它替你做重要决定。它可以帮你收集信息、梳理思路,但拍板的,必须是你自己。

应用边界的三条红线

基于以上,我认为普通人使用LLM,至少要守住三条边界:

不用于高风险决策

别拿它问“该不该手术”“投哪只股票”“孩子上哪所学校”。它可以提供背景资料,但不能替代专业咨询。不轻信事实性陈述

凡涉及数据、日期、法规、科学结论,务必交叉验证。记住:LLM的答案≈维基百科+知乎+小红书的混合体,有精华也有谣言。不交出思考主权

最危险的不是AI太强,而是人变懒。如果凡事都让AI代劳思考,久而久之,你会失去提问、质疑、整合信息的能力——那才是真正的“被取代”。

未来:从“通用嘴替”走向“专业协作者”

值得期待的是,LLM正在进化。不再是单一的“通才”,而是结合检索(RAG)、工具调用(Function Calling)、多模态(图文音)的智能体(Agent)。比如,未来的AI医生可能不会直接开药,而是:

→ 调取你的电子病历

→ 检索最新临床指南

→ 对比类似病例

→ 生成治疗选项供医生参考这时,它不再是“答案机器”,而是增强人类专家的协作者。同样,教育领域的理想形态,不是AI替学生写作文,而是像苏格拉底一样不断提问,引导学生自己思考。

结语:善用其利,警惕其幻

大型语言模型无疑是这个时代最激动人心的技术之一。它降低了知识获取门槛,提升了生产力,甚至改变了人机交互的方式。但请永远记住:它是一面镜子,照出的是人类已有知识的影子,而非智慧本身。你可以用它写情书、改简历、学编程、练英语,但别指望它告诉你“人生该怎么活”。真正的智能,依然扎根于人类的好奇、怀疑、共情与责任。在这个AI满天飞的时代,最稀缺的能力,或许不是会用AI,而是知道自己什么时候不该信它。